La moderación en redes sociales: del fact-checking a las notas de comunidad

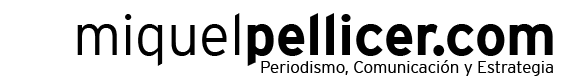

TikTok presenta Footnotes, un sistema de anotaciones comunitarias, mientras las plataformas sociales experimentan con nuevos modelos de moderación que aún no logran sustituir la verificación profesional

TikTok ha lanzado en Estados Unidos Footnotes, una nueva función que permite a usuarios añadir anotaciones contextuales a vídeos publicados en la plataforma. Se trata del último intento de una red social por sumarse a una tendencia creciente: la moderación de contenidos impulsada por la comunidad. Pero, ¿es este un verdadero avance en la lucha contra la desinformación o simplemente una estrategia más para trasladar la responsabilidad al usuario? Pongamos un ejemplo. En unos días se celebran las elecciones en Canadá y algunos datos son preocupantes desde la perspectiva de la desinformación. Según apunta The Guardian, más de una cuarta parte de los canadienses han estado expuestos a contenido político falso en las redes sociales que es “más sofisticado y más polarizador políticamente”. Mientras el país se prepara para votar en una elección federal, algunos estudios advierten que las plataformas deben aumentar las protecciones en medio de una “aceleración dramática” de la desinformación en línea en las últimas semanas de la campaña. ¿Son suficientes las medidas de moderación planteadas por la mayoría de las redes sociales? Con la compra de X por parte de Elon Musk, la priorización de la libertad de expresión fue clave para desmontar las medidas planteadas en cuanto a moderación por parte de la antingua Twitter. La tendencia desde entonces en el conjunto de las plataformas sociales ha sido dejar gran parte de la moderación en manos de los propios usuarios.

Una tendencia que se expande, no siempre con éxito

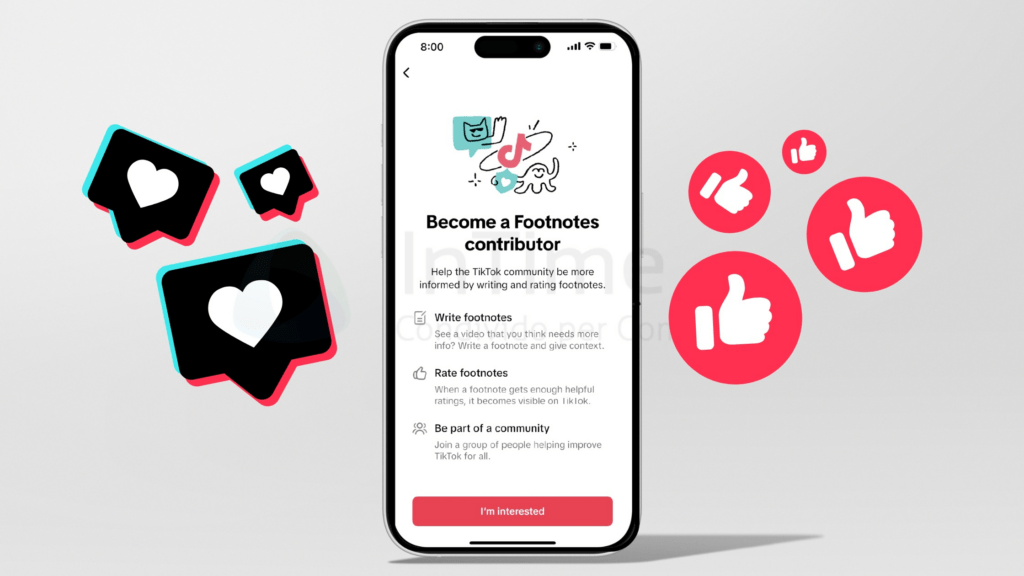

TikTok no es la primera en explorar este camino. X (antes Twitter) lanzó en 2021 Community Notes, un sistema que permite a ciertos usuarios añadir notas a tuits para contextualizarlos. El modelo ha sido elogiado por su transparencia, pero también criticado por su escasa eficacia: según Poynter, menos del 10% de las notas generadas se muestran públicamente, debido a un algoritmo que exige consenso entre ideologías opuestas. El resultado: muchas notas relevantes quedan invisibles. YouTube estrenó su propio sistema en 2024, y Meta lo sigue probando de forma interna sin demasiada claridad sobre su funcionamiento. En la mayoría de los casos, los datos no son públicos, y la participación comunitaria no sustituye (ni puede hacerlo del todo) la verificación profesional.

Footnotes, un modelo híbrido

Aquí es donde TikTok podría marcar cierta diferencia. La red de vídeos cortos mantiene sus acuerdos con más de 20 organizaciones de fact-checking profesionales, mientras introduce Footnotes como una capa adicional de contexto generada por usuarios. Solo podrán participar personas mayores de 18 años sin infracciones recientes, y el enfoque, según la plataforma, será consensuado y moderado. Este diseño híbrido podría ayudar a sortear algunos de los cuellos de botella que han afectado a otras plataformas. Los profesionales seguirán siendo responsables de detectar los casos más virales y dañinos de desinformación, mientras que los usuarios podrán aportar contexto a aquellos contenidos que no alcancen ese umbral. Aun así, persisten las dudas: ¿será suficiente para marcar la diferencia? ¿Y hasta qué punto puede TikTok garantizar que estas notas no se conviertan en terreno para disputas ideológicas o sesgos?

Meta: del fact-checking profesional al control interno

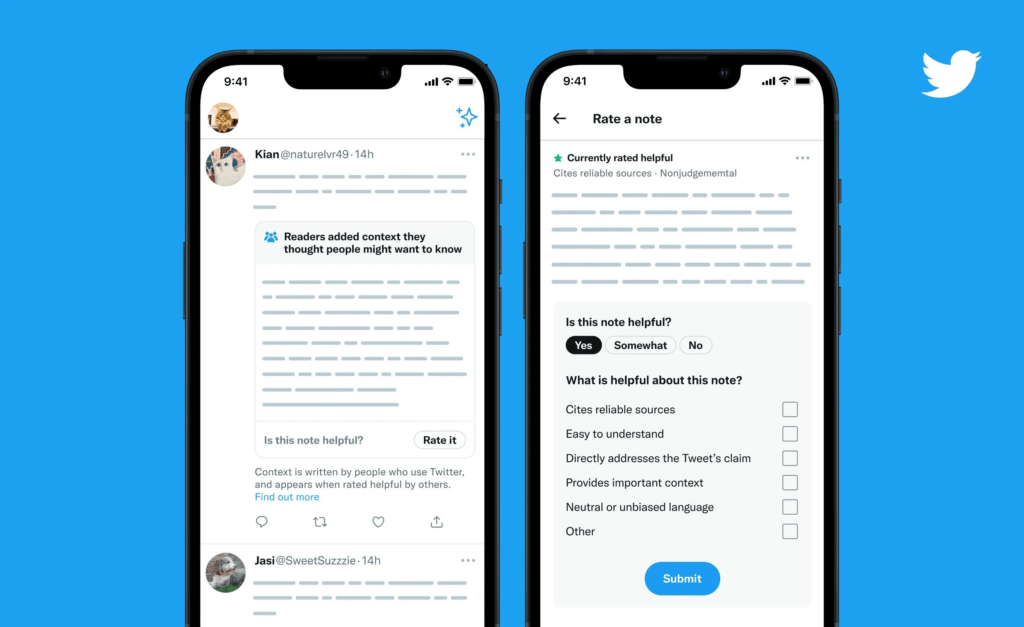

Meta, que durante años se había posicionado como una de las plataformas más comprometidas con la verificación profesional, ha empezado a reducir y desdibujar ese compromiso. La compañía mantenía acuerdos con más de 80 verificadores independientes en todo el mundo (como Maldita, Newtral o AFP), que marcaban contenidos como falsos y reducían su visibilidad en Facebook e Instagram. Sin embargo, desde principios de 2025, Meta está abandonando el uso de verificadores de hechos independientes en Facebook e Instagram, reemplazándolos con «notas comunitarias» estilo X, donde los comentarios sobre la precisión de las publicaciones quedan en manos de los usuarios. El director ejecutivo Mark Zuckerberg dijo que los moderadores externos eran «demasiado políticamente sesgados» y que era «hora de volver a nuestras raíces en torno a la libertad de expresión». «El anuncio de Zuckerberg es un intento flagrante de congraciarse con la administración entrante de Trump, con implicaciones perjudiciales», dijo a BBC Ava Lee, de Global Witness, un grupo de campaña que se describe a sí mismo como un grupo que busca exigir cuentas a las grandes tecnológicas.

Meta ha desarrollado una versión propia de Community Notes, sin datos públicos, sin métricas de impacto y sin colaboración clara con verificadores externos. A pesar de que los fact-checkers continúan detectando y etiquetando contenidos falsos, sus informes muchas veces no se integran en los sistemas de señalización visibles para los usuarios. Este giro hacia un modelo más opaco y centralizado contrasta con la transparencia relativa de X o el enfoque mixto de TikTok. Y plantea una pregunta crucial: ¿puede una red social autorregular la veracidad sin mecanismos externos de control?

Moderación no es igual a verificación

Pero hay que tener en cuenta que es importante no confundir conceptos. Footnotes no es fact-checking. La verificación periodística es una práctica profesional con criterios editoriales, transparencia metodológica y responsabilidad ética. Las anotaciones comunitarias pueden ser útiles, pero no pueden ni deben sustituir ese trabajo. En ese sentido, hay un riesgo real de que el público interprete estas herramientas como garantías de veracidad, cuando en realidad se trata más de moderación distribuida que de verificación rigurosa.

Entre el compromiso real y el maquillaje algorítmico

En plena crisis de confianza hacia las plataformas sociales, muchas compañías están optando por mostrar esfuerzos visibles contra la desinformación sin asumir plenamente el coste que implica una verificación profesional y a gran escala. Apostar por la comunidad puede ser una solución parcial, pero sin transparencia, supervisión editorial y métricas claras, el resultado puede ser más cosmético que efectivo. TikTok, con su enfoque mixto, tiene una oportunidad de demostrar que se puede innovar sin renunciar al rigor. Pero eso dependerá menos de la herramienta y más de cómo se implemente, se supervise y se comunique.

Footnotes representa un nuevo intento de las plataformas por reinventar la moderación en la era de la inteligencia artificial y la saturación informativa. No es una solución milagrosa, pero podría ser un paso útil si se acompaña de compromiso editorial, transparencia de datos y una clara separación entre participación ciudadana y verificación profesional. La pregunta no es si la comunidad debe ayudar, sino cómo se estructura esa ayuda para fortalecer —y no erosionar— la confianza en el periodismo y en la información verificada.