Guía sobre la manipulación audiovisual

Hace unos días aparecían unas imágenes de Nancy Pelosi, la presidenta de la Cámara de Representantes de Estados Unidos, en el que la veía con serios problemas de vocalización. El vídeo se viralizó de tal forma que tuvo millones de visitas en pocas horas. Como se pudo demostrar, se trataba de un vídeo manipulado para desprestigiar a la veterana demócrata. Advertimos que se extiende este fenómeno de contenidos manipulados, ya sea por edición o por postproducción.

El vídeo de Pelosi es lo que se llama deep fake pero no todos los contenidos audiovisuales manipulados son deep fakes.

Glenn Kessler desde el Washington Post ha publicado una interesante guía titulada ‘Ver es no creer’ para diferenciar los tipos de manipulación de imágenes. Internet está cada vez más poblada con videos falsos y engañosos. Millones de usuarios ven estos videos, difundidos por políticos, grupos de defensa y usuarios cotidianos. Por este motivo, Kessler a través del proyecto ‘Fact Checker’ en el que se desarrolla verificación de contenidos, ha propuesto desarrollar un lenguaje universal para etiquetar videos manipulados y responsabilizar a los creadores y distribuidores de este tipo de contenidos.

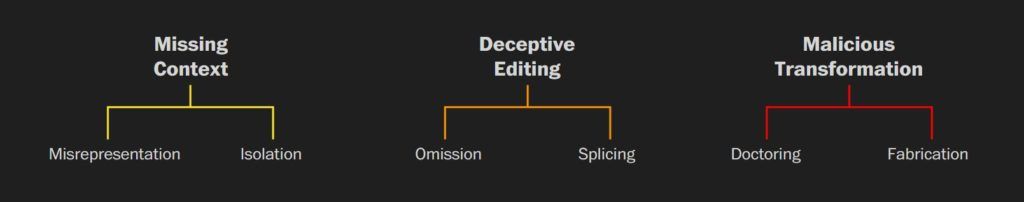

Así, hablamos de tres formas de alterar los contenidos: las imágenes tomadas fuera de contexto, editadas engañosamente o alteradas deliberadamente. Estas categorías se desglosan en subcategorías, que se muestran a continuación.

A través del Fact Checker del periódico de Jeff Bezos, Kessler ha detallado la manipulación de imágenes a través de tres tipos básicos. Hablamos de tres ámbitos en los que el engaño se realiza de forma de menos a más compleja:

- Contexto perdido. Imágenes fuera de contexto.

- Edición engañosa. Se manipula la edición para engañar

- Transformación maliciosa. Se desarrolla a través de contenidos que pueden estar manipulados a través de Inteligencia Artificial.

Imágenes fuera de contexto

Es la categoría más básica en las tipologías de vídeos manipulados, aunque no son los menos problemáticos ya que proliferan cada vez más y su distribución es muy sencilla a través de los canales sociales y apps de mensajería. En esta categoría podemos encontrar:

Contenidos tergiversados

La presentación de un video sin alteraciones de manera incorrecta, tergiversa las imágenes y confunde al espectador. Usar fechas o ubicaciones incorrectas son ejemplos de subvertir el contexto. Cada vez son más habituales supuestos vídeos que han ocurrido en un lugar del mundo y que intentan justificar actitudes xenófobas.

No, esta agresión de alumnos a su profesora no sucede en Granada, Almería, Melilla o Cataluña. Ni en ningún lugar de España.

— MALDITO BULO (@malditobulo) 24 de junio de 2019

▶ Es Brasil.

Seguís preguntando por este bulo en nuestro Whatsapp, 📲 655 198 538 https://t.co/ajb2xs9epv

Contenidos aislados

Compartir un breve clip de un video más largo crea una narrativa falsa que no refleja el evento como ocurrió. Los videos de punto de vista también pertenecen a esta categoría cuando promueven solo un ángulo de una historia. En este caso, el ejemplo que pongo a continuación és un contenido que está fuera de contexto ya que, oh sorpresa, unas palabras de Trump se sacan de contexto ya que en el vídeo no dijo que «los inmingrantes no son humanos, son animales». El presidente de Estados Unidos estaba calificando así a las maras centroamericanas que hacen tráfico humanos con los migrantes.

🚫 Esto es #fakenews (hilo):

— Miquel Pellicer 🎗 (@mik1977) 7 de abril de 2019

Trump: “Los inmigrantes no son humanos, son animales”

pic.twitter.com/1E0LSlPOKs

Edición engañosa

La segunda división nos lleva a considerar contenido audiovisual manipulado todos aquellos vídeos en los que hay una edición de las imágenes con una intencionalidad de desinformación. En estos casos los vídeos han sido editados y reorganizados para provocar equívocos. En esta categoría encontramos dos tipologías:

Contenidos omitidos

Hay una edición de grandes partes del vídeo que hace que cuando se presenta el vídeo parece que la narración está completa pero todo lo contrario, faltan elementos claves. Hablamos de una técnica utilizada para sesgar la realidad.

La lucha política en Estados Unidos se está convirtiendo en un campo de batalla en el que los candidatos a las elecciones presidenciales de 2020 se están viendo envueltos en este tipo de estrategias. En este caso, Ryan Saavedra, periodista del medio derechista The Daily Wire publicó un vídeo de Joe Biden en el que supuestamente el candidato demócrata llamaba a hacer la revolución. El vídeo había sido editado para eliminar el contexto en el que se explicaba el «hacer una revolución física», como advierten diferentes analistas estadounidenses.

Democratic presidential candidate Joe Biden says that the way he would deal with Senate Republicans who oppose his agenda is with a “brass knuckle fight,” later adds: “Let’s start a real physical revolution if you’re talking about it” pic.twitter.com/GQPmDGxJpo

— Ryan Saavedra (@RealSaavedra) 18 de junio de 2019

Contenidos empalmados

La edición conjunta de trozos de vídeo diferentes altera fundamentalmente la historia que se está contando.

Pongamos como ejemplo lo que hicieron en Conservative Review (CRTV) con una falsa entrevista a la demonizada Alexandria Ocasio-Cortez. El medio conservador publicó un vídeo que no era más que un remix entre respuestas de Ocasio-Cortez de una entrevista de la PBS y pregunta de Allie Stuckey, presentadora de CRTV. El medio describió la pieza como satírica pero lo cierto es que la entrevista la vieron millones de personas y no estamos seguros que todos los usuarios entendieron la naturaleza cómica del vídeo.

Transformación maliciosa

En este caso estamos hablando que parte o todo el vídeo ha sido manipulado para transformar el contenido.

Contenidos adulterados

Alterar los frames de un vídeo (recortar, cambiar de velocidad, usar Photoshop, copiar audio o agregar o eliminar información visual) puede engañar al espectador. Ya hemos visto el vídeo de Pelosi como ejemplo de esta categoría, cuando se relantizó la velocidad para hacer dudar de su integridad física.

Otro ejemplo de vídeo adulterado lo encontramos en el que compartió a través de las redes sociales la entonces secretaria de Prensa de la Casa Blanca, Sarah Huckabee Sanders. No conforme con haber vetado al periodista de CNN Jim Acosta, Sanders publicó un vídeo ‘arreglado’ para justificar la suspensión a Jim Acosta, a quien acusó de haber sido violento con una joven que trabaja para la Casa Blanca.

Contenidos fabricados

De mayor complejidad, el uso de la Inteligencia Artificial sirve para crear imágenes falsas de alta calidad, simula el audio y cambiar de manera convincente las imágenes de fondo. Deepfakes y otros contenidos sintéticos entran en esta categoría.

Ya hemos visto en alguna ocasión las imágenes de Jennifer Lawrence – Steve Buscemi en lo que parece un inocente juego pero que en realidad no deja de ser una evolución preocupante de la desinformación a través de los contenidos audiovisuales.

¿Hacia dónde van las deep fakes?

Nos puede hacer gracia ver al temible Rasputín hacer un cameo cantado ‘Halo’ de Beyoncé.

Son impactantes los resultados del Laboratorio de Inteligencia Artificial (IA) de Samsung. Está desarrollando un proyecto de desarrollo audiovisual por el cual mediante la IA puede servir para desarrollar animaciones parlantes en 3D de modelos históricos. El trabajo de Egor Zakharov, Aliaksandra Shysheya, Egor Burkov y Victor Lempitsky avanza en la muestra de una recopilación de datos no solo en modelos de personas reales y que podemos captar a través de la grabación sino también a través de ejemplos históricos a partir de fotografía o cuadros. Los resultados son muy sorprendentes desde el punto de vista científico.

Pero, ¿qué sucede cuando el vídeo está protagonizado por Mark Zuckerberg explicando los escalofriantes planes de Facebook con nuestros datos?

El enorme trabajo de la verificación de datos del Washington Post nos ofrece esta fantástica guía para detectar contenidos audiovisuales fraudulentos. La mayor complejidad de estos contenidos falsos exige un trabajo aún mayor en la detección y en el uso de herramientas periodísticas.

Por otra parte, hay que tener en cuenta que deberíamos hablar no solo de vídeos sino también de audios. Hablar de contenidos audiovisuales también significa tener en cuenta todo aquello que afecta a los contenidos de sonido, casi igual o más difíciles de detectar que los vídeos. Además, la proliferación del fenómeno podcast nos aporta claves para determinar qué tipo de contenidos serán viralizados.

Ya no es que podamos escuchar a John Fitzgerald Kennedy pronunciar el discurso que no pronunció en Dallas el día de su asesinato, es que en la actualidad las deep fakes y la manipulación audiovisual pueden impactar en las elecciones de 2020 de la misma forma que las fake news afectaron las elecciones de 2016.

Atentos a lo que está viniendo. Debemos estar preparados, como periodistas pero también como ciudadanos. Qué interesante sería que el ‘ver no es creer’ se pudiera transformar en ‘ver para creer’.